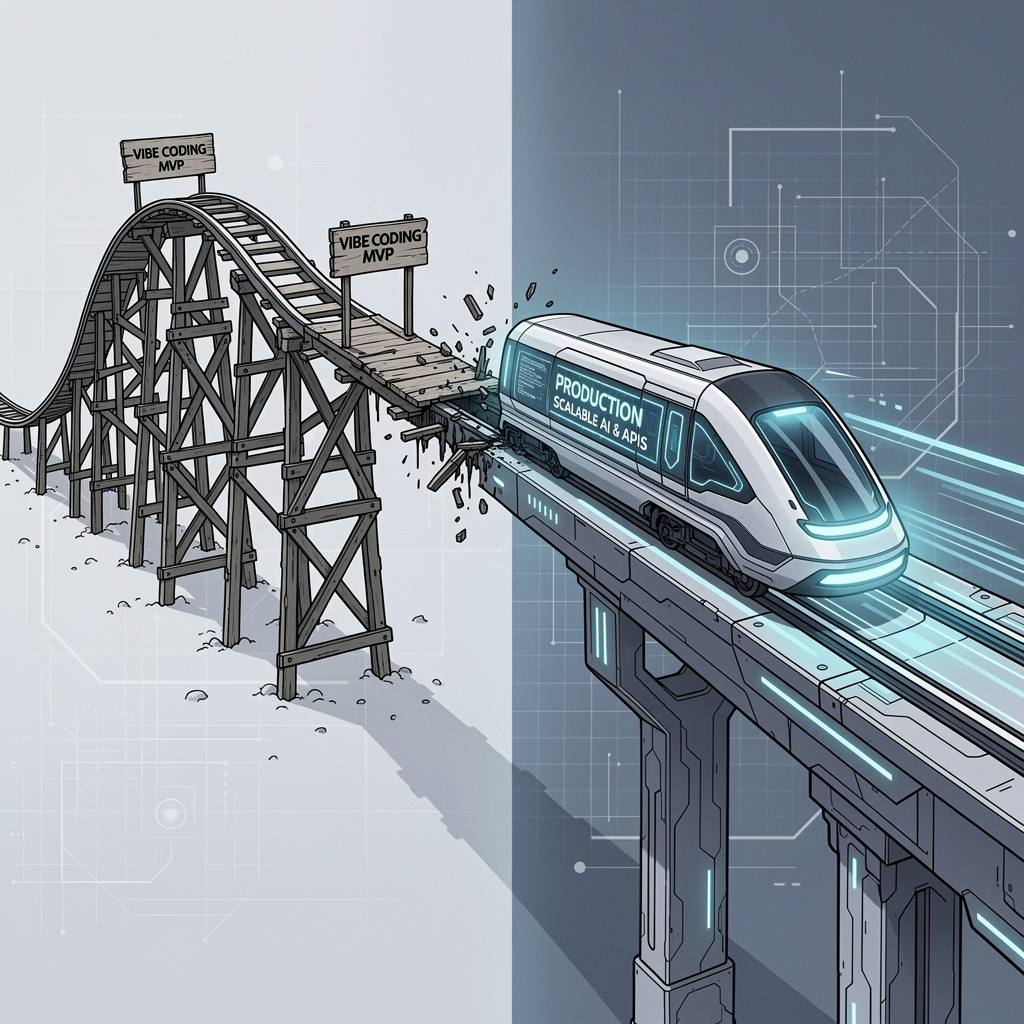

El auge de herramientas de Inteligencia Artificial (IA) generativa y Large Language Models (LLMs) ha democratizado la creación de prototipos. Hoy, un equipo pequeño puede crear un MVP (Producto Mínimo Viable) funcional en semanas. A este ritmo frenético, lo llamamos a veces “Vibe Coding”: construir algo rápido, que se “siente” bien, y que prueba el valor de mercado.

Su MVP ya genera valor: tiene unos pocos usuarios, la prueba de concepto funcionó, y ahora la junta directiva pregunta: “¿Cuándo podemos poner esto en producción a gran escala?”

Aquí es donde el “Vibe Coding” choca con la realidad de la Ingeniería de Software. El camino de un script funcional a una API REST escalable y segura es complejo, y una arquitectura deficiente le costará la fortuna que su MVP prometía ahorrarle.

1. El Desafío de la Latencia y el Costo de Inferencia

Los modelos de IA, especialmente los LLMs, tienen demandas de recursos muy altas. Un MVP puede usar una API de terceros (como OpenAI), pero la dependencia genera latencia, falta de control y un costo variable que puede dispararse al escalar.

A. Optimizando el Despliegue

Para escalar, es necesario pasar de la dependencia externa a un despliegue optimizado, lo que implica:

- Contenedorización (Docker/Kubernetes): Empaquetar el modelo y sus dependencias para un despliegue consistente.

- Elección de Hardware: Determinar si se necesita una GPU (costosa) o si el modelo puede ser lo suficientemente eficiente para correr en CPU.

- Modelo de Inferencia: Implementar batching (procesar solicitudes en lotes) para optimizar el uso de recursos y reducir el costo por solicitud.

2. La Falta de Observabilidad y Monitoreo (MLOps)

Un script de MVP solo tiene un estado: “funciona o falla”. Un sistema de IA en producción necesita MLOps (Machine Learning Operations), un conjunto de prácticas para garantizar la fiabilidad.

En producción real, los problemas no son solo de código, sino de datos:

- Desvío de Datos (Data Drift): El modelo aprende de unos datos, pero el entorno cambia (tendencias, lenguaje). Si no se monitorea la calidad de las predicciones, el modelo “se vuelve tonto” silenciosamente.

- Monitorización de Latencia y Tasa de Éxito: Las APIs de IA deben tener endpoints de salud que informen sobre la carga del modelo y su rendimiento en tiempo real. Esto garantiza un SLA (Acuerdo de Nivel de Servicio) aceptable para sus clientes.

3. Seguridad y Consistencia de la API

El MVP de IA probablemente tiene un endpoint simple. Una aplicación de producción necesita una API robusta y segura.

- Autenticación y Autorización: Implementación de tokens (JWT o OAuth) para asegurar que solo los usuarios autorizados accedan al servicio de inferencia.

- Rate Limiting: Prevenir ataques DDoS y controlar el gasto limitando el número de solicitudes por usuario o por IP, una característica esencial para cualquier API REST comercial.

- Control de Versiones: Los modelos de IA cambian constantemente. Es fundamental que su API maneje el versionamiento (

/api/v1/ia/predictvs./api/v2/ia/predict) para evitar romper la funcionalidad de los clientes existentes mientras se experimenta con nuevos modelos.

4. Estructura de Datos y Escalabilidad del Backend

El “Vibe Coding” a menudo ignora la estructura de datos a largo plazo. Al escalar, el backend de su MVP debe ser capaz de manejar grandes volúmenes de datos de entrada/salida y logs de inferencia.

- Bases de Datos Escalables: Migrar de soluciones locales a bases de datos distribuidas y optimizadas para la nube (ej: DynamoDB, Aurora).

- Arquitectura de Microservicios: Separar la lógica de inferencia de IA del resto de servicios de su negocio. Si el modelo falla, solo el microservicio de IA se ve afectado, no toda la plataforma.